Det 21. århundrede har været vidne til, at AI (kunstig intelligens) udfører opgaver, som om let at besejre mennesker ved skak eller hurtigt lære dem fremmedsprog.

En mere avanceret opgave for computeren ville være at forudsige en gerningsmands sandsynlighed for at begå en anden forbrydelse. Det er jobbet for et AI-system kaldet COMPAS (Correctional Offender Management Profiling for Alternative Sanctions). Men det viser sig, at værktøjet ikke er bedre end en gennemsnitlig fyr og også kan være racistisk. Nå, det er præcis, hvad et forskergruppe har opdaget efter grundig undersøgelse af AI-systemet, der er meget brugt af retlige institutioner.

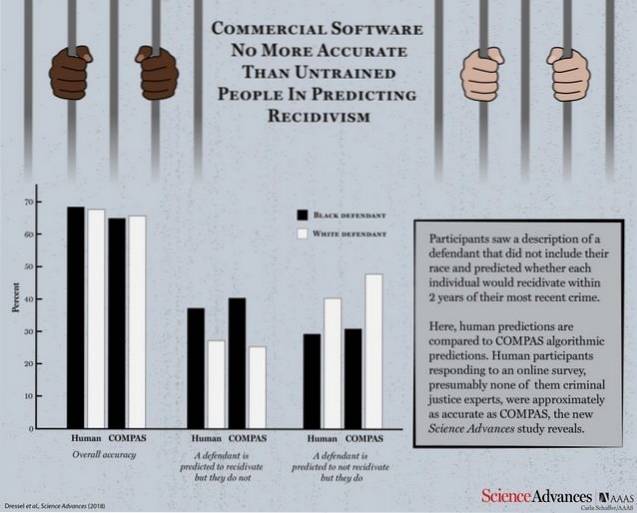

Ifølge et forskningsoplæg, der blev offentliggjort af Science Advances, blev COMPAS stillet over for en gruppe menneskelige deltagere for at teste dets effektivitet og kontrollere, hvor godt det går mod de logiske forudsigelser fra en normal person. Maskinen og de menneskelige deltagere fik 1000 testbeskrivelser indeholdende alder, tidligere forbrydelser, køn osv. Af lovovertrædere, hvis sandsynlighed for gentagne forbrydelser skulle forudsiges.

Med betydeligt mindre information end COMPAS (kun 7 funktioner sammenlignet med COMPAS 137) er en lille skare af ikke-eksperter lige så nøjagtige som COMPAS til at forudsige tilbagevenden.

COMPAS fik en samlet nøjagtighed på 65,4% til at forudsige tilbagevenden (tendensen hos en dømt kriminel til at fornærme), hvilket er mindre end den samlede forudsigelsesnøjagtighed for menneskelige deltagere, der står på 67%.

Nu er det bare at tage et øjeblik og reflektere over i dit sind, at AI-systemet, der ikke klarer sig bedre end en gennemsnitlig person, blev brugt af domstole til at forudsige tilbagevenden.

Kommerciel software, der i vid udstrækning bruges til at forudsige tilbagefald, er ikke mere nøjagtig eller retfærdig end forudsigelserne fra mennesker med ringe eller ingen strafferetlig ekspertise, der reagerede på en online undersøgelse.

Endnu værre er det faktum, at systemet blev fundet lige så modtageligt for racefordomme som dets menneskelige kolleger, da de blev bedt om at forudsige sandsynligheden for tilbagevenden fra beskrivelser, der også indeholdt racemæssige oplysninger om lovovertrædere. Du bør ikke blive for overrasket der, da AI er kendt for at tage de mønstre, som dens menneskelige lærere vil programmere det til at lære.

Selvom begge sider ikke er drastisk korte med at opnå en acceptabel nøjagtighedsscore, rejser pointen med at bruge et AI-værktøj, der ikke er bedre end et gennemsnitligt menneske, mange spørgsmål.

Gadgetshowto

Gadgetshowto